ビジネスの現場では、データが様々な場面で活用されるようになっています。しかし、膨大なデータから価値ある情報を見つけ出すためには、適切な管理と分析が不可欠です。このような状況の中で、Google の BigQuery は有効な解決策として注目されています。

BigQuery は、大量のデータを効率的に分析できるクラウドデータウェアハウスサービスで、これまで不可能だったような複雑な分析も簡単に実行できます。ただし、BigQuery は機能が豊富で、使いこなすには専門知識が必要です。

そこで本記事では、BigQuery の基本から具体的な活用方法、トラブルシューティングまでを、わかりやすく解説します。これから BigQuery を利用しようと考えているエンジニアの方は、ぜひ参考にしてください。

データ分析基盤とは?

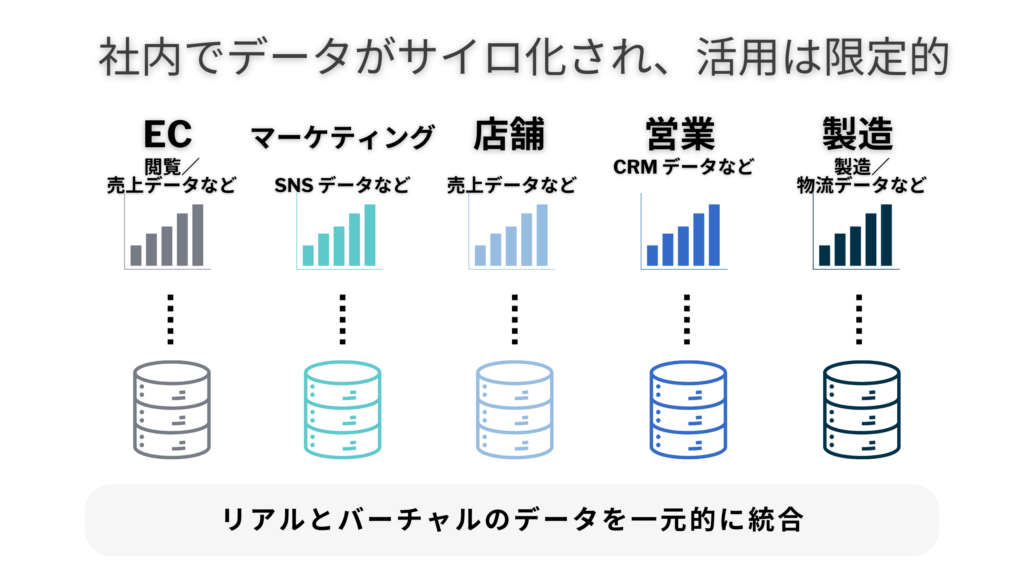

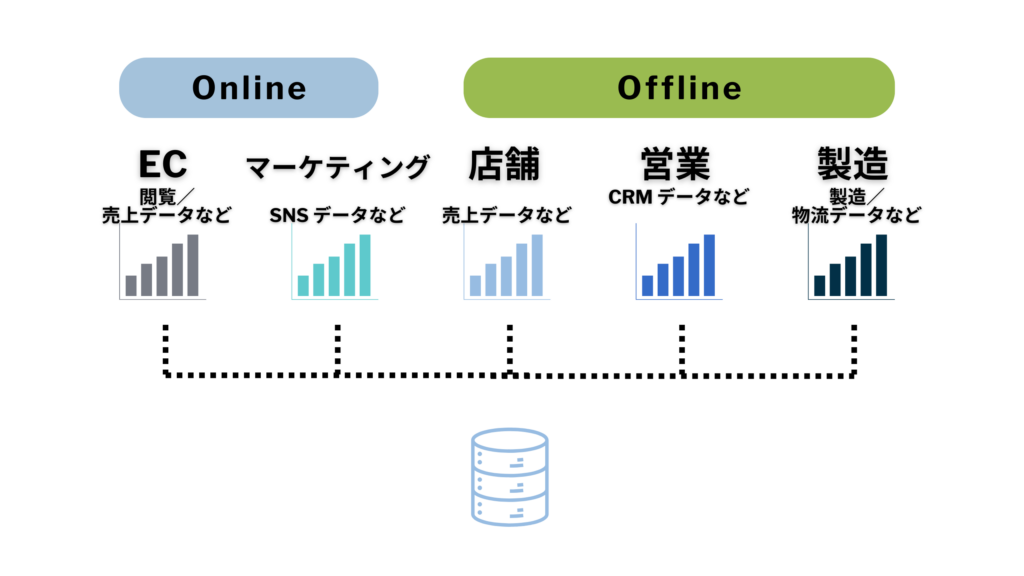

データ分析基盤とは、組織のデータを一元的に管理・活用するためのシステムです。

- 営業データ

- 顧客データ

- 財務データ

など、さまざまなデータソースから収集したデータを、クレンジング、変換、統合などの処理を行い、データウェアハウスに蓄積します。そして、データ分析担当者は、分析ツールを使って多角的な分析を行い、経営層や現場にビジネスに役立つインサイトを提供します。

データ分析基盤の重要性と基本構成

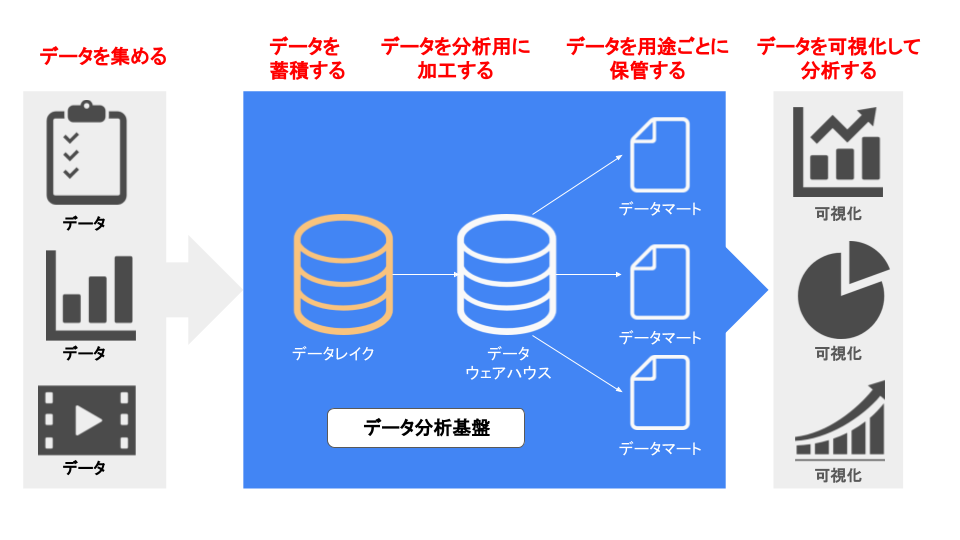

データ分析基盤は、データを収集・保存・分析・加工し、ビジネスの意思決定を支援するシステムです。基本的な構成要素として、顧客情報や商品情報などを保存する「データベース」、分析用にデータを集積・加工する「データウェアハウス」、あらゆる種類のデータを保存する「データレイク」などがあります。

これらの技術により、組織は大量のデータを効率的に処理・分析できます。初めてこれらに触れる人は複雑に感じるかもしれませんが、実際には顧客行動の分析、商品レコメンドシステム、市場動向の予測など、ビジネスの各領域で日常的に活用されています。

BigQuery を活用した分析基盤のメリット

BigQuery は Google が提供するフルマネージド型データウェアハウスサービスです。ペタバイト級の大規模データも高速処理でき、複雑なクエリも柔軟に実行可能です。Web ブラウザベースのインターフェースがわかりやすく、サーバー管理は不要で従量課金制です。

これにより、ユーザーはコストを抑えながらデータ分析基盤を構築でき、的確な意思決定や競争力の向上が期待できます。BigQuery は、規模を問わずあらゆる企業に適した、高速・スケーラブル・使いやすく低コストなデータ分析ソリューションです。

ユースケースで学ぶ BigQuery データ分析基盤の構築方法

実際のユースケースから、BigQuery を活用した分析基盤の構築例を見ていきましょう。

BigQuery を活用した社内データ分析基盤の構築事例

株式会社 MonotaRO は、データドリブン戦略を推進するため、Google Cloud の BigQuery を中心に社内データ分析基盤を構築しました。これにより、従来の課題を克服し、顕著な業務改善を実現しています。

導入前の主な課題

MonotaRO が直面していた主な課題は、従来の分析基盤では急増するデータ量を効率的に処理することができなかったことにありました。データのバッチ処理には24時間以上を要し、これがビジネスの迅速な対応を困難にしていました。また、ウェブログや広告データなどのマーケティング情報を十分に活用できていなかったことも、大きな課題の一つでした。

新しいアーキテクチャ

MonotaRO は BigQuery を軸に、以下のアーキテクチャを採用しました。

この移行により、クラウドベースの BigQuery に変更され、MySQL からのデータはニアリアルタイムで BigQuery に同期されるようになり、データの整合性が保持されました。さらに、アナリティクス360からのウェブログデータも自動的に BigQuery に転送されるようになり、これによりデータ分析の幅が大きく広がりました。

導入後のメリット

総計100億レコードを BigQuery に集約したことで、新しい分析が可能になりました。処理速度も大幅に改善され、かつては負担だった重いバッチ処理が日次で実行できるようになりました。こうした変化は、データに基づく業務改善を加速させることにつながっています。

また、データ分析を行うメンバーが4倍に増えたことで、非 IT エンジニアでもデータ分析・可視化が容易になりました。分析レポートの数も月に30本から300本へと大きく増加し、データドリブンな PDCA サイクルを回すことで、業務改善をより一層スピードアップできるようになっています。このようなデータ活用を通じて、意思決定の迅速化と精度向上が図られ、MonotaRO のビジネスモデル強化に貢献しています。

MonotaRO の BigQuery 導入は、ビッグデータ活用によるビジネス加速の典型例です。データの集約と分析を通じて、業務プロセス改善と意思決定の迅速化を実現しています。他社のデータドリブン戦略推進の一助となるでしょう。

BigQuery を活用したリアルタイムデータ分析基盤の構築事例

三井ホームは、住宅建築から不動産開発、賃貸住宅など幅広いサービスを提供する企業です。同社はデータ分析によるサービス向上を目指し、Google Cloud を活用した統合データ分析基盤を構築しました。その取り組みと成果を見ていきましょう。

導入前の主な課題

導入前は、データ収集に手動作業が多く、多大な工数がかかっていました。BI ツールでのデータ加工にも制約があり、十分な分析ができていませんでした。さらに、データが複数の場所に分散して保管されていたため、運用の負荷が高くなっていました。

また、ダッシュボードの表示速度の遅さが問題となっており、別の問題として、マクロ視点からの分析の不足がありました。

新しいアーキテクチャ

これらの課題を解決するため、同社は次のようなアーキテクチャを構築しました。

出典元:Google Cloud ブログ

Cloud Data Fusion を使ってデータ収集を自動化し、BigQuery を中央のデータ分析基盤として導入しました。Dataform を使用してコードベースの ELT( Extract Load Transform ) プロセスを実現し、Looker Studio で新しいダッシュボードを作成しました。さらに、Cloud Functions を利用して非構造化データを含む複雑なデータ加工を行い、Cloud Scheduler によってこれらのデータ加工タスクを定期的に実行するアーキテクチャを構築しました。

導入後のメリット

この新しいアーキテクチャの導入により、共通指標を用いたデータ分析が可能になり、全国規模でのマクロな視点からの分析およびリアルタイムでの業務改善が実現しました。アンケートの横断分析や感情分析を通じて、顧客満足度の向上も達成できました。また、国産材の利用率や ZEH 率など、SDGs に関する取り組みの可視化が可能になり、ダッシュボードの表示速度は4倍に向上しました。これにより、データ処理の自動化が進み、大幅な工数削減を実現できました。

このように同社では、データを活用して業務改善と顧客満足度向上を実現しています。統合データ分析基盤の構築は、他の業界や企業にも参考になる取り組みと言えるでしょう。

BigQuery を活用したマーケティング基盤の構築事例

株式会社 LIXIL は、住宅設備や建材の製造販売を手がける大手企業です。月間200万人ものユーザーが Web サイトを訪れるため、訪問者一人ひとりに合わせた最適なコンテンツ提供が求められていました。この課題を解決するため、同社はどのようにデータ分析を強化したのか見ていきましょう。

導入前の主な課題

月間約200万人が訪れる Web サイトには、キッチンやトイレなどの商品情報を求める方、ショールームを訪れたい方、見積もりを取りたい方、工務店を探している方など、顧客のニーズは多岐にわたります。そのため、訪問者一人ひとりの状況に合わせた、適切なタイミングで最適なコンテンツを提供することが求められていました。

しかし、Web サイト訪問者の多様なニーズに対応するための、分析精度の高いデータ管理とパーソナライズされたコンテンツ提供を実現するシステムがなく、顧客のニーズに適時かつ的確に応えることが困難な状況でした。

新しいアーキテクチャ

BigQuery を中心に、アナリティクス360やレコメンドエンジンなど、Google プロダクトと外部サービスを組み合わせた新しいアーキテクチャを構築しました。

出典元:Google Cloud ブログ

アナリティクス360から BigQuery へのデータエクスポート機能を用いて、Web サイト訪問時に生成される一意の識別子「 clientId 」をユーザー識別子として統一しました。この「 clientId 」は、アナリティクス360でのカスタムディメンションに保存され、BigQuery での分析とレコメンドエンジンへの連携に使用されています。さらに、実店舗の来館情報と Web 上の行動データを「 clientId 」で連携させることで、オンラインとオフラインの行動を統合した分析を実現しました。

導入後のメリット

この新しいアーキテクチャの導入により、訪問者のニーズに応じたパーソナライズされたコンテンツの提供が可能となり、コンバージョンレートと集客効率が大幅に向上しました。これは、分析精度の向上とデータを基にした広告配信の効率化を実現することで達成されました。

BigQuery のトラブルシューティング

分析基盤の構築と運用には様々な課題が伴います。ここでは、一般的な問題とその対処方法、よくある質問について説明します。

ジョブの失敗

ジョブが失敗する主な原因は、以下の3つです。

- クエリのエラー

クエリを注意深く確認し、文法や構文のミスがないことを確認する必要があります。

- リソース使用量の超過

リソース使用量を定期的に監視し、限界に近づいた場合はクエリを調整するか、リソースを増強する必要があります。

- アクセス権限の不足

適切なアクセス権限が設定されているか確認し、必要に応じて権限を調整する必要があります。

アクセス管理の複雑さ

BigQuery のアクセス管理は柔軟性が高い反面、複雑になりがちです。効率的な管理には、以下の点が重要です。

- 権限レベルの理解

プロジェクト、データセット、テーブルレベルでの権限を理解する。

- 最小権限の割り当て

ユーザーやグループには必要最小限の権限のみを割り当てる。

- IAM ポリシーの一元管理

IAM ポリシーを活用し、権限管理を一元化する。

- 定期的なレビュー

不要な権限が付与されていないか定期的にレビューする。

- 組織全体のポリシー策定

必要に応じて組織全体のアクセスポリシーを策定し運用する。

BigQuery に関するよくある質問

BigQuery の利用に関連して、よくある質問を紹介します。

BigQuery のデータ型は?

BigQuery でサポートされるデータ型は以下の通りです。

- STRING (文字列)

- INTEGER (整数)

- FLOAT (浮動小数点数)

- BOOLEAN (真偽値)

- TIMESTAMP (タイムスタンプ)

- DATE (日付)

- TIME (時間)

- DATETIME (日時)

- STRUCT (構造体)

- ARRAY (配列)

これらのデータ型を適切に使い分けることで、様々なデータ形式を効率的に扱うことができます。

一時テーブルとは?

一時テーブルは、クエリ実行時に中間結果を一時的に保存するためのテーブルです。以下のような特徴があります。

- クエリ完了時に自動的に削除され、永続的なストレージを消費しない

- コスト効率が良いデータ処理が可能

- ユーザーが明示的に作成し、複数クエリで結果を再利用できる

- データ分析の柔軟性が高まる

一時テーブルを適切に活用することで、BigQuery を効率的に利用できます。

まとめ

本記事では、BigQuery を中心とした効率的なデータ分析基盤の構築から運用、トラブルシューティングまで、幅広く解説しました。BigQuery は優れた機能を有しており、これらを最大限活用することで、ビジネスにおけるデータの価値を引き出すことができます。

当社センティリオンシステム 大阪事業所では、BigQuery の運用やデータ基盤の構築にとどまらず、ランニングコストの最適化や Google Cloud のサポート、コンサルティングまで幅広くサービスを提供しています。

以下のような課題をお持ちの方は、ぜひお気軽にご相談ください。

- データ基盤を構築したいが社内に知見がない

- BigQuery を活用したい

- 信頼性の高いシステム構築や具体的な実装方法

- クラウド活用を推進するための開発体制作りが進まない

- 既存資産をどのようにクラウド移行するか検討する知見が不足している

- 内製化するためのクラウド開発スキルを持った人材が不足している

- コスト削減の実現方法に悩んでいる

- SRE を実現したい

貴社の状況に合わせて、体制づくり支援や開発計画支援、クラウド開発スキルアップ支援など、様々な支援メニューを提供しています。無料相談も可能なため、まずは問い合わせフォームからご連絡いただければと思います。

本記事を参考にして、 Google Cloud の導入および BigQuery の活用を検討してみてはいかがでしょうか?